无监督学习

文章目录

无监督学习包含算法

聚类

- K-means(K均值聚类)

降维

- PCA

一家广告平台需要根据相似的人口学特征和购买习惯将美国人口分成不同的小组,以便广告客户可以通过有关联的广告接触到他们的目标客户。

Airbnb需要将自己的房屋清单分组成不同的社区,以便用户能更轻松地查阅这些清单。

一个数据科学团队需要降低一个大型数据集的维度的数量,以便简化建模和降低文件大小。

我们可以怎样最有用地对其进行归纳和分组?我们可以怎样以一种压缩格式有效地表 征数据?这都是无监督学习的目标,之所以称之为无监督,是因为这是从无标签的数 据开始学习的。

K-means算法

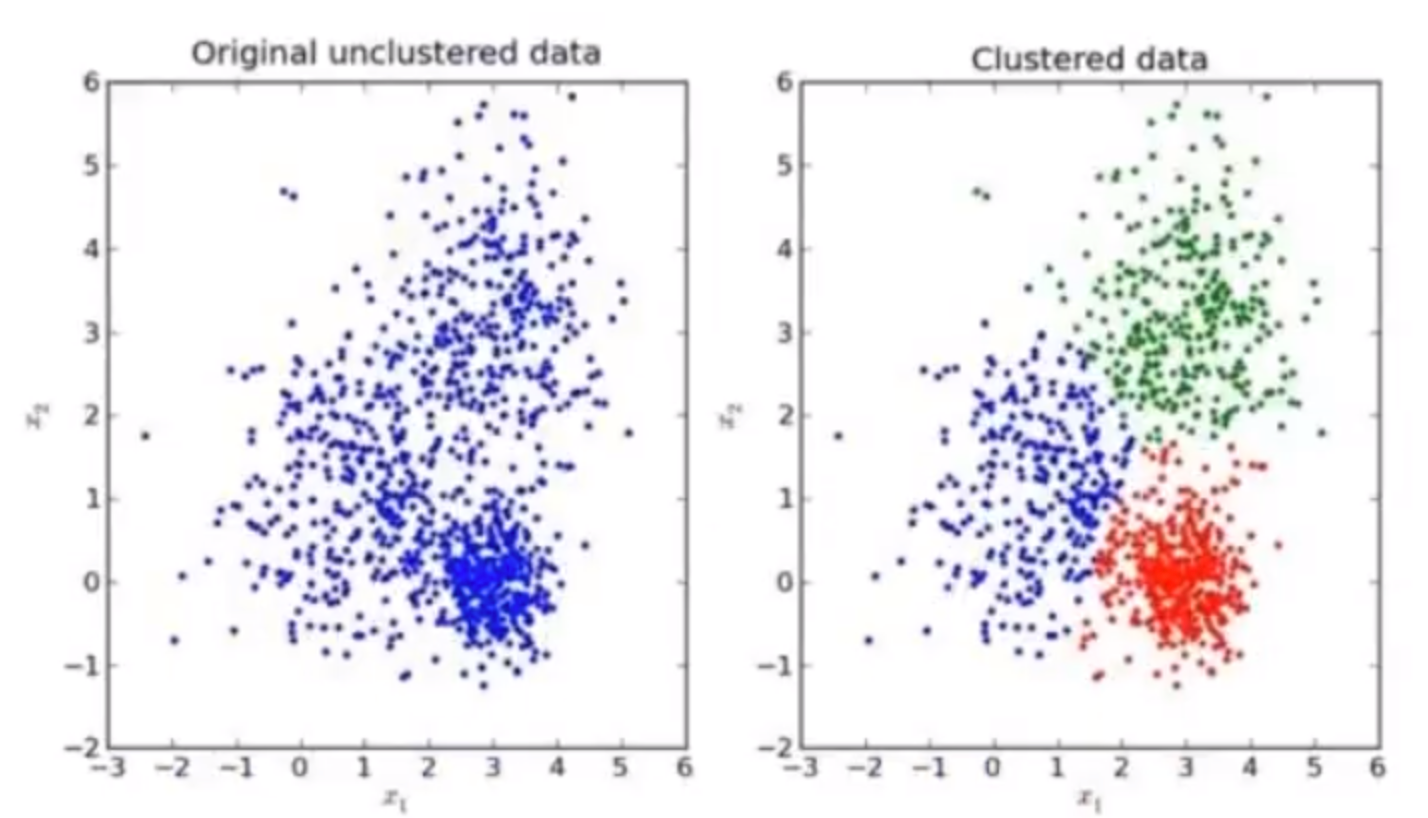

我们先来看一下一个K-means的聚类效果图

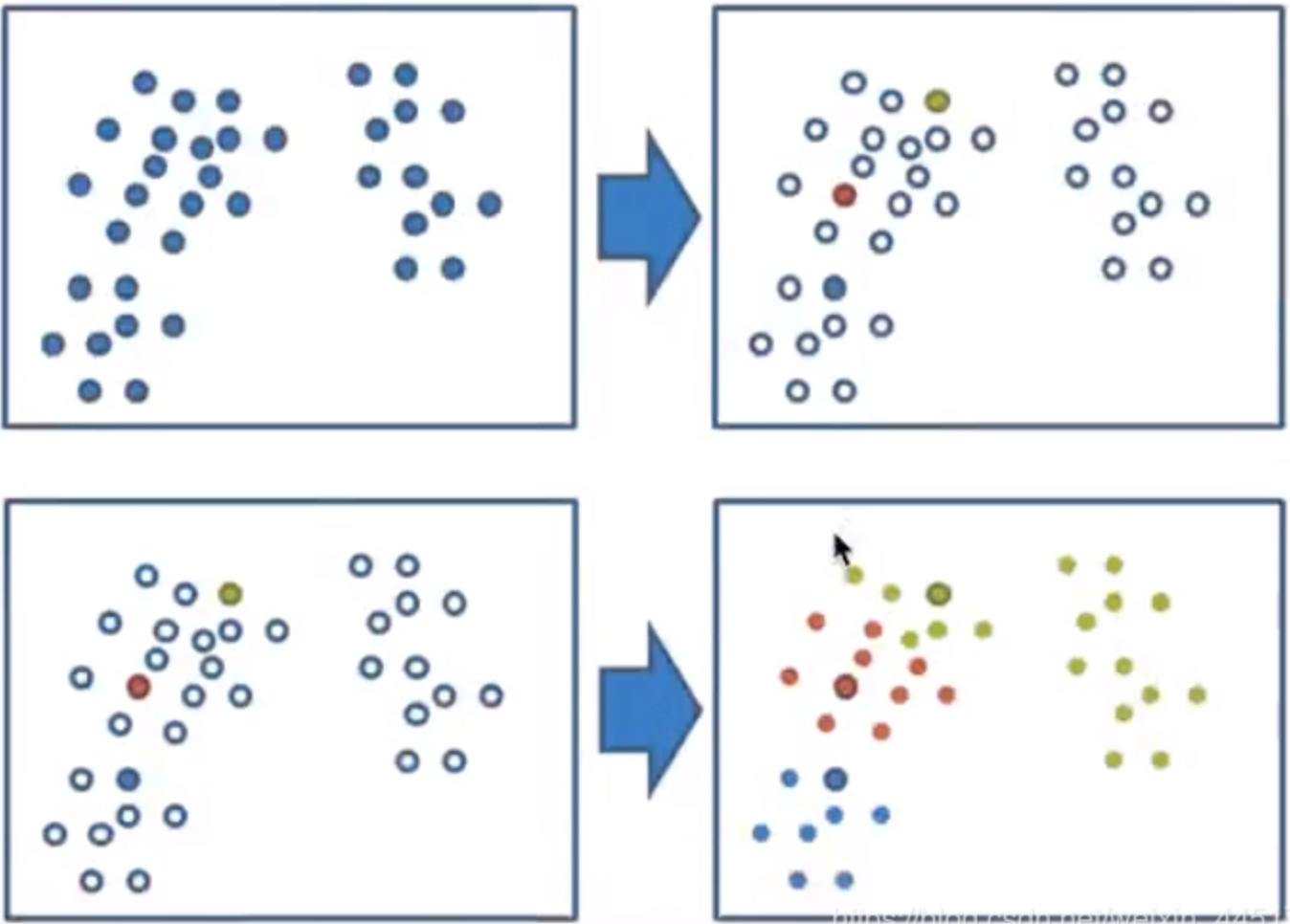

K-means聚类步骤:

- 随机设置K个特征空间内的点作为初始的聚类中心

- 对于其他每个点计算到K个中心的距离,未知的点选择最近的一个聚类中心点作为标记类别

- 接着对着标记的聚类中心之后,重新计算出每个聚类的新中心点(平均值)

- 如果计算得出的新中心点与原中心点一样,那么结束,否则重新进行第二步过程

API

sklearn.cluster.KMeans(n_clusters=8,init='k-means++)- k-means聚类

- n_clusters:开始的聚类中心数量

- init::初始化方法,默认为’k-means++'

- labels_:默认标记的类型,可以和真实值比较(不是值比较)

性能评估指标

- 轮廓系数

$$ s c_{i}=\frac{b_{i-} a_{i}}{\max \left(b_{i}, a_{i}\right)} $$

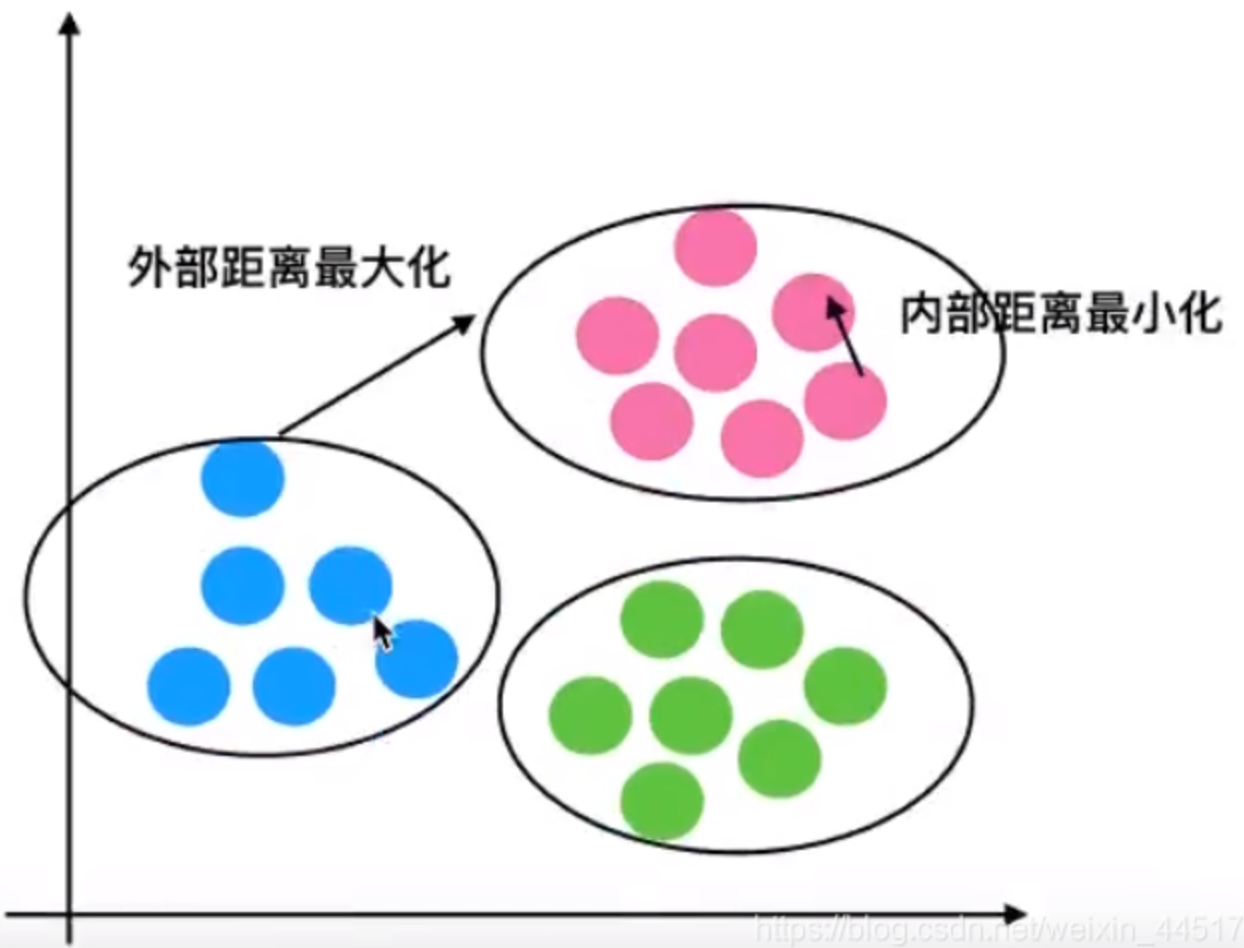

注:对于每个点为已聚类数据中的样本,b1为到其它族群的所有样本的距离最小值,a为ⅰ到本身簇的距离平均值。最终计算出所有的样本点的轮廓系数平均值

- 轮廓系数值分析

分析过程(我们以一个蓝1点为例):

计算出蓝1离本身族群所有点的距离的平均值ai

蓝1到其它两个族群的距离计算出平均值红平均,绿平均,取最小的那个距离作为bi

根据公式:极端值考虑:如果bi»ai:那么公式结果趋近于1;如果ai»>b_i:那么公式结果趋近于-1

结论

如果 $b_i»a_i$: 趋近于1效果越好,$b_i«a_i$:趋近于-1,效果不好。轮廓系数的值是介于[-1,1],越趋近于1代表内聚度和分离度都相对较优。

- 轮廓系数API

sklearn.metrics.silhouette_score(X,labels)- 计算所有样本的平均轮廓系数

- X:特征值

- labels:被聚类标记的目标值

文章作者 zput

上次更新 2023-11-09